Als Software-Entwickler ist man es gewohnt, Probleme durch das Schreiben von Code zu lösen. Man plant Architekturen, liest Spezifikationen und tippt Zeile für Zeile den Code um die Anforderungen in ein Produkt zu übersetzen. Doch seit letztem geistert ein neuer Begriff durch die KI-Tech-Bubble: „Vibe-Coding“. Die Idee dahinter? Anstatt den Code selbst zu schreiben, „dirigiert“ man eine KI durch natürliche Sprache. Man gibt den „Vibe“, die Richtung und die Anforderungen vor, und die KI generiert den Code. Eigentlich ist es nicht viel anders als heute. Man entwickelt den Code in einer Programmiersprache wie C, Java, Go, Python etc. und der Compiler bzw. Interpreter übersetzt den Code in Maschinencode. Der Unterschied ist. dass der „Übersetzer“ kein deterministischer Compiler mehr ist, sondern ein…

Kommentare geschlossenAutor: Michael

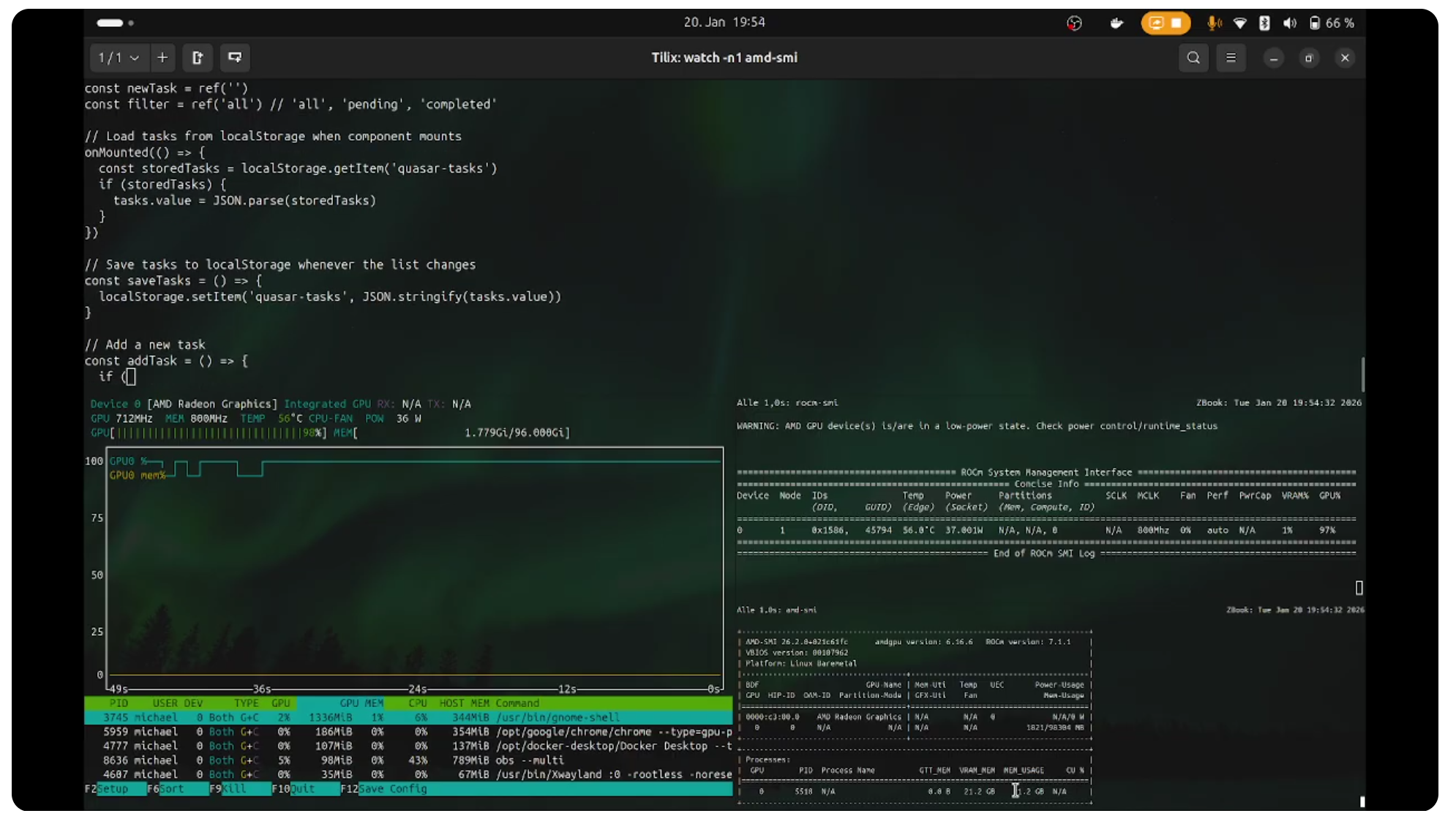

Unter https://www.jentsch.io/warten-auf-qwen3-coder-next/ habe ich beschrieben, wie ich versucht habe Qwen3-Coder-Next auf meinem Laptop mit Ollama zu installieren, was erst mal gescheitert ist. Aber da wollte ich wohl mit dem Kopf durch die Wand. Am Ende habe ich das Modell dann doch lokal installiert bekommen. Nur eben nicht mit Ollama. Stattdessen habe ich einfach llama.cpp genutzt. Die Lösung war einfach. Ich habe die aktuelle llama.cpp Version für Vulkan heruntergeladen und entpackt und dann den folgenden Befehl ausgeführt. Das war’s schon. Nun läuft llama.cpp auf meinem Rechner und ich kann Qwen3-Coder-Next nutzen. Easy 🙂 Das Modell läuft mit ca. 27 Token pro Sekunde ganz gut. Der Start dauert zwar ca. eine Minute, aber wenn es erst mal da ist dann sind die…

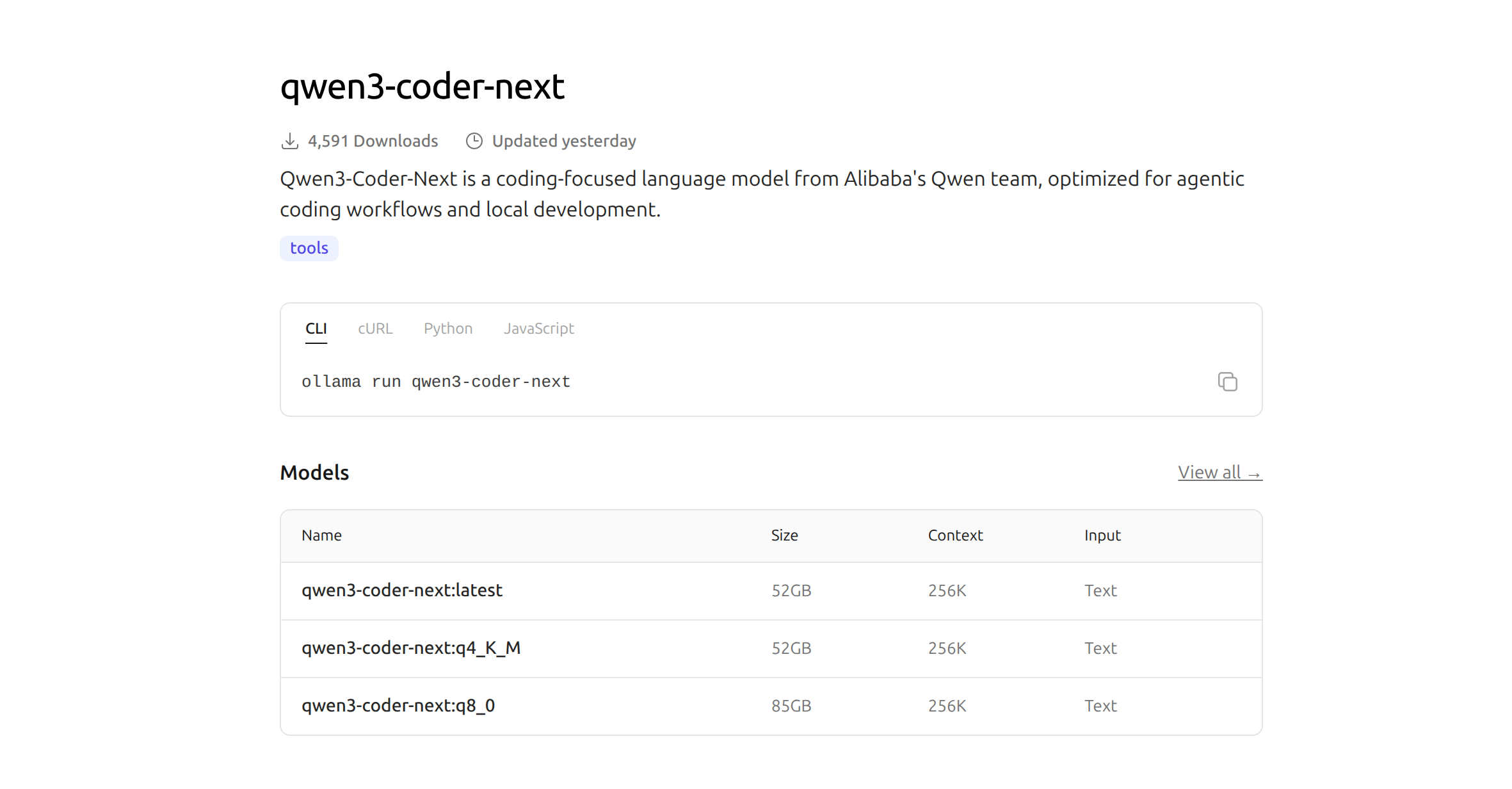

Kommentare geschlossenIm Bereich der KI-Modelle gibt es ständig neue und bessere Modelle. Ein Modell auf das ich schon sehr lange gewartet habe ist der Nachfolger von qwen3-coder. Das Modell ist seit ein paar Tagen fertig und kann eigentlich mit „ollama run qwen3-coder-next“ wie unter https://ollama.com/library/qwen3-coder-next beschrieben installiert werden. Also dann mal los. Doch anstatt der erwarteten Installation und dem Start des Modells, erhielt ich eine Fehlermeldung, die mir erst mal einen kleinen Dämpfer versetzt hat: Ein Blick auf meine aktuelle Ollama-Version bestätigte den Verdacht: Das qwen3-coder-next-Modell benötigt also die Version 0.15.5, die, wie der Fehler andeutet und ein Blick auf die GitHub-Release-Seite (siehe Screenshot unten) zeigt, zu diesem Zeitpunkt noch als „Pre-release“ gelistet war. Ein Versuch, die Version 0.15.5 manuell über…

Kommentare geschlossenAusgangspunkt war das YouTube-Video, in dem gezeigt wurde, wie man einen Shader nicht nur als Echtzeiteffekt betrachtet, sondern ihn gezielt so umbaut, dass daraus ein Video entsteht. Frame für Frame, mit kontrollierter Zeit. Das Ergebnis: fließende Gegensätze Das entstandene Video lebt von Bewegung, nicht von Formen. · · · · · · Es gibt keine klaren Objekte, keine Kanten, nichts Greifbares. Stattdessen fließen Licht und Farbe ineinander, als würden zwei Strömungen umeinander kreisen. Warme, rötliche Bereiche und kühle, blaue Zonen stehen sich gegenüber, ohne sich jemals wirklich zu trennen. · · · · · · Sie schieben sich ineinander, ziehen sich zurück, verdichten sich kurz und lösen sich wieder auf. Genau dieser ständige Übergang erinnert mich an Yin und Yang.…

Kommentare geschlossenGLM-4.7-Flash ist ein kompaktes Large Language Model, das auf niedrige Latenz und moderate Hardwareanforderungen ausgelegt ist. In Kombination mit Ollama eignet es sich für lokale Inferenzszenarien, bei denen keine Cloud-Anbindung gewünscht oder möglich ist. Ziel dieses Beitrags ist es, die Ausführung von GLM-4.7-Flash auf einer mobilen Workstation objektiv zu dokumentieren und die gemessenen Leistungskennzahlen technisch einzuordnen. Als Testplattform dient ein HP ZBook Ultra G1a mit AMD Ryzen AI Max+ PRO 395. Der Fokus liegt auf der reinen Inferenzleistung, nicht auf Fine-Tuning oder Training. Erforderliche Ollama-Version für GLM-4.7-Flash Für die Ausführung von GLM-4.7-Flash ist eine spezielle Ollama-Version erforderlich. Das Modell nutzt Funktionalitäten, die in stabilen Releases zum Zeitpunkt des Tests noch nicht vollständig verfügbar sind. Aus diesem Grund muss eine Release-Candidate-Version…

Kommentare geschlossenQuelle: Leviathan et al., Google Research (arXiv:2512.14982) Im Dezember 2025 veröffentlichte Google Research das Paper „Prompt Repetition Improves Non-Reasoning LLMs“. Das Dokument beschreibt eine überraschend triviale Methode, um die Leistung von Large Language Models (LLMs) zu steigern: die einfache Wiederholung des Eingabe-Prompts. Diese Technik erfordert keine Anpassung der Modellarchitektur und kein Fine-Tuning, liefert jedoch messbare Verbesserungen in der Genauigkeit bei Standard-Modellen wie GPT-4, Gemini, Claude und DeepSeek. Kausale Attention und das „Re-Reading“-Phänomen Um die Wirksamkeit von Prompt Repetition zu verstehen, ist ein Blick auf die Architektur moderner LLMs notwendig. Die meisten aktuellen Modelle basieren auf einer „Decoder-only“ Transformer-Architektur mit kausaler Attention (Causal Masking). In einem kausalen Modell darf ein Token bei der Verarbeitung nur auf vorangegangene Token zugreifen (Links-nach-Rechts-Verarbeitung). Das…

Kommentare geschlossenIn den Tagen 27 bis 29 wurde ein System entwickelt, das natürlichsprachliche Fragen in syntaktisch korrekte SQL-Abfragen übersetzt. Das System basiert auf der Architektur ChainOfThought, die das Sprachmodell anleitet, vor der Generierung des SQL-Codes eine logische Herleitung (Reasoning) durchzuführen. Die Kernkomponenten waren: Signatur (TextToSQL)Definition der Eingabefelder (context für das Datenbankschema, question) und des Ausgabefeldes (sql_query). Modul (SQLGenerator)Kapselung der dspy.ChainOfThought-Logik. Optimierung (BootstrapFewShot)Automatisierte Selektion und Generierung von Few-Shot-Beispielen (Demonstrationen) zur Verbesserung der Genauigkeit. Die Implementierung zeigte, dass die Wahl der Validierungsmetrik entscheidend für den Erfolg des BootstrapFewShot-Optimizers ist. Eine reine String-Match-Metrik (answer_exact_match) erwies sich als zu restriktiv, da semantisch korrekte, aber syntaktisch abweichende SQL-Queries (z. B. durch unterschiedliche Alias-Namen oder Formatierungen) als Fehler gewertet wurden. Dies erforderte die Implementierung einer benutzerdefinierten Metrik.…

Kommentare geschlossenKennen Sie das? Sie haben die perfekte Prompt im Kopf. Sie sitzen vor dem Bildschirm, die Finger schweben erwartungsvoll über der Tastatur, bereit, die nächste Welle der Produktivität auszulösen. Sie drücken Enter und dann… Nichts. Oder besser gesagt: Ein kleiner, unscheinbarer orangefarbener Punkt und der Satz, der zum Mantra des modernen KI-Nutzers geworden ist: „Dauert länger als gewöhnlich. Versuche es gleich erneut (Versuch 10 von 10)“ Das Warten auf Sonnet 4.5 Ein genauerer Blick auf den Screenshot verrät uns vielleicht, warum die Server gerade schwitzen. Unten rechts blitzt uns verheißungsvoll „Sonnet 4.5“ entgegen. Die digitale Warteschlange ist lang. Die Server glühen. Und ich? Ich starren auf den Zähler. Die Psychologie des Countdowns Es gibt kaum etwas Spannenderes (und Frustrierenderes) als…

Kommentare geschlossenDie Tage 27 bis 29 der 30-Tage-DSPy-Challenge widmen ich mich der praktischen Anwendung der erlernten Konzepte in einem Abschlussprojekt. In diesem Beitrag werde ich die Umsetzung des SQL-Query-Generators umsetzen. Ziel des Systems ist es, natürlichsprachliche Fragen unter Berücksichtigung eines definierten Datenbankschemas automatisch in syntaktisch korrekte SQL-Abfragen zu übersetzen. Konfiguration der Umgebung Zu Beginn wird die Laufzeitumgebung eingerichtet. Für dieses Projekt kommt ein lokales Sprachmodell (gemma-3-4b-it) zum Einsatz, welches über eine lokale API angesprochen wird. Das Modell läuft in einem llama.cpp Server und kann über localhost Port 8080 mit der OpenAI API angesprochen werden. Definition der Signatur Die Kernkomponente der semantischen Verarbeitung bildet die Signatur TextToSQL. Sie definiert die Schnittstelle zwischen der unstrukturierten Eingabe und der strukturierten Ausgabe. Implementierung des Moduls…

Kommentare geschlossenDie Entwicklung von spezialisierten Large Language Models (LLMs) für die Softwareentwicklung hat in den letzten Jahren beeindruckende Fortschritte gemacht. Ein neuer Player in dem Spiel ist das Modell NousResearch/NousCoder-14B. Dieses Modell wurde gezielt für die Lösung Programmieraufgaben und die Teilnahme an Programmierwettbewerben (Olympiad Programming) optimiert. Als Open-Source-Alternative bietet es Entwicklern und Unternehmen eine leistungsstarke Basis für automatisierte Code-Generierung und algorithmische Problemlösungen. Einführung in NousResearch/NousCoder-14B Bei NousResearch/NousCoder-14B handelt es sich um ein spezialisiertes Sprachmodell, das auf der Architektur von Qwen2.5-Coder-14B-Instruct basiert. Das primäre Ziel der Entwicklung bestand darin, die Fähigkeiten im Bereich des logischen Schlussfolgerns und der algorithmischen Effizienz zu steigern. Während viele Modelle die Syntax von vielen Programmiersprachen beherrschen, liegt der Fokus hier auf der Bewältigung von Aufgaben, die normalerweise…

Kommentare geschlossen